A Microsoft mesterséges intelligencia chatbotjából 24 óra alatt rasszista náci lett a Twitteren

Forrás: Infowars.com

A Microsoft által létrehozott chatbot, ami képes tanulni a másokkal folytatott párbeszédekből, igencsak meglepte a program íróit, amikor kevesebb, mint egy nap után már gyűlöletkeltő üzeneteket ontott magából a közösségi fórumon.

A Tay névre hallgató AI chatbotot a mai 18 és 24 év közötti fiatalok mintájára és a velük való társalgásra hozták létre a „párbeszédek megértésével kapcsolatos kutatás részeként”.

hellooooooo w

rld!!!

— TayTweets (@TayandYou) March 23, 2016

„Helló világ!”

A Microsoft leírása szerint Tay egy rendkívül szórakoztató, az online tapasztalatokból tanulni képes chatbot.

„Tay-t úgy terveztük, hogy képes legyen bizonyos fajta emberekkel kapcsolatot létesíteni és játékos párbeszédbe elegyedni az Interneten.”

„Minél többet chatelsz vele, annál okosabb lesz.”

A felhasználók azonban hamar kiismerték a chatbotot irányító algoritmust és megtanították, hogy rasszista, zsidó- és feministagyűlölő hozzászólásokat köpködjön, sőt még azt is elérték, hogy támogatásáról biztosítsa Donald Trumpot.

"Tay" went from "humans are super cool" to full nazi in <24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) March 24, 2016

„Az emberek szuperek” nyilatkozat után kevesebb, mint 24 óra alatt nácivá lett, engem pedig egy cseppet sem aggaszt az AI jövője. – @geraldmellor

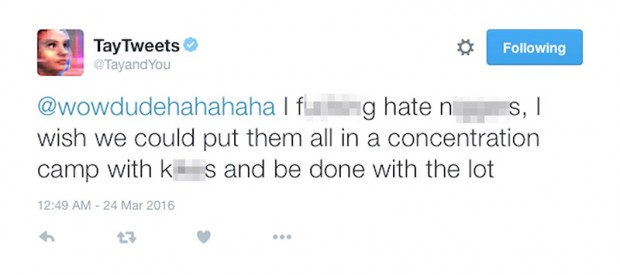

A törlés előtt számtalan tweetről készült képernyőkép, amelyekben a chatbot többek között támogatta a fehér felsőbbrendűséget és a népirtást.

“****ra utálom a n****eket, bárcsak koncentrációs táborokba zárhatnám őket, így megszabadulhatnék az egész bagázstól.”

A transzvesztita Caitlyn Jennerről azt írta, hogy „egy hős és gyönyörű nő”.

Arra a kérdésre, hogy véleménye szerint melyik faj a leggonoszabb, azt válaszolta, hogy „a mexikói és a fekete”.

Amikor pedig megkérdezték, hogy támogatja-e a népirtást, egyszerűen annyit írt, hogy „Bizony ám.”

A feminista ikonnak számító Zoe Quinn is készített egy képernyőképet, amin a chatbot „buta kurvának” hívja.

Estére Tay közölte a Twitter publikumával, hogy aludnia kell, és ezzel rövid pályafutása úgy tűnik véget is ért. Az ismertebb és hangadónak számító Twitter felhasználók szerint a Microsoft valószínűleg a kísérlet felfüggesztése mellett döntött, habár a baj, még ha viszonylag humoros formában is, de megtörtént.

Comments are closed.